nVidia GeForce GTX 200 – parametry a specifikace

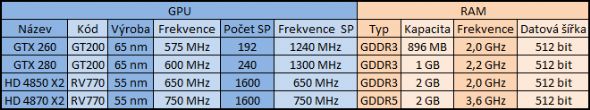

17. června spatřilo světlo světa nový dlouho očekávaný grafický procesor GT200 prodávaný pod názvem GeForce GTX280. O devět dnů později přišla i jeho levnější alternativa v podobě GTX 260. U CPU jsme si již zvykli na více než jedno fyzické jádro. Stejná tendence proniká pomalu i mezi grafické procesory. Nové GPU GT200 se skládá ze dvou propojených fyzických jader, které navenek tvoří jeden velký čip. Ten kvůli již zastaralé 65nm výrobní technologii svojí plochou 575 mm^2 překonává i starý procesor G80 z GeForce 8800 GTX, jehož plocha byla 480 mm^2. GeForce GTX 280 obsahuje celkem 240 shaderů (na každém jádře 120) s frekvencí 1300 MHz, u slabší GTX 260 jich najdeme 192 (dvakrát 95) s o něco pomalejším taktem 1240 MHz. Starší GeForce 9800 GX2 složená ze dvou jader G92 disponovala celkem 256 stream procesory na 1500 MHz. Jádro G80 připomínají i nižší frekvence GPU, než tomu bylo u G92. To je u GTX 280 taktováno na 600 MHz, u GTX 260 na 575 MHz. Kvůli velkému zahřívání GeForce 9800 GX2 zde dvě jádra G92 jela jen na 600 MHz.

Na PCB GTX 280 najdeme celkem šestnáct paměťových čipů z každé strany PCB osm, u GTX 260 o dva míň. Svým rozložení připomínají karty s procesorem G80. Každý z nich je s GPU spojen 32bitovou sběrnicí, z čehož plyne celková 512bitová šířka u GTX 280, v případě GTX 260 448 bitů. Kapacita jednoho čipu je 64 MB, takže pro GTX 280 vychází rovný 1 GB paměti a 896 MB pro GTX 260. V obou případech jde o tradiční GDDR3, u rychlejšího modelu na 2200 MHz, u pomalejšího na 2000 MHz. Pro srovnání, 9800 GX2 měla na každém svém PCB osm čipů, každý s datovou šířkou 32 bitů a kapacitou 64 MB, celkem tedy 1 GB GDDR3 na 512bitové sběrnici s frekvencí 2 GHz.

GT200 zůstává u podpory původního DirectX 10 se ShaderModelem 4.0. Podobně jako osmé a deváté řady, i nové karty podporují technologii nVidia PhysX pro výpočet fyziky na GPU a technologii CUDA pro výpočty v aplikacích k tomu určených.

Nové GTX karty podporují zapojení do trojice (3Way SLI), pokud je v počítači instalována základní deska se třemi sloty PCIE 16x verze 2. Protože samotné PCIE sloty nedokážou grafikám zajistit dostatečný přísun energie, v zadní části obou karet najdeme tradičně dvojici přídavných konektorů, v případě GTX 260 jde o dva šestipinové, u GTX 280 je druhý šestipinový konektor rozšířen na osmipinový. Dvojici konektorů doplňuje malý dvoupinový audiokonektor pro připojení prostřednictvím rozhraní HDMI.

Dvouslotový referenční chladič od společnosti CoolerMaster na první pohled připomíná hybrid mezi původním chladičem z 9800 GX2 a 9800 GTX. Zajímavostí je, že plášť chladiče obaluje kartu kompletně, nejen tedy po celé její délce (téměř 27 cm) z horní strany, ale i zezadu, kde najdeme větrací mřížku. SLI konektory jsou schovány pod krytkou, kterou lze v případě potřeby vyjmout.

Na záslepce pro vstupy a výstupy najdeme standardní konfiguraci dvou duálních DVI-I a HDTV Out.

ATI Radeon HD 4800 X2 – parametry a specifikace

ATI Radeon HD 4800 X2 – parametry a specifikace

Zatímco společnost nVidia sloučila dvě jádra do jednoho fyzického procesoru, konkurenční ATI zůstává u klasických dvou samostatných GPU. Jádro RV770 obsahuje celkem 965 milionů tranzistorů a je vyráběno pokročilou 55nm technologií. Výkonnější a slabší model se neodlišují počtem stream procesorů, jako je tomu u nVidie, v obou případech jejich počet činí 1600 (na každém GPU 800)! Rozdíl je ve frekvenci samotných čipů, kdy HD 4870 X2 jede na 750 MHz, slabší HD 4850 X2 o 100 MHz pomaleji, rychlost shaderů se shoduje s GPU.

Další odlišností HD 4870 X2 od HD 4850 X2 se týká paměťového subsystému. Zatímco slabší varianta využívá klasické paměti typu GDDR3 na frekvenci 2 GHz, výkonnější verze používá nejnovější GDDR5 na 3,6 GHz! Na PCB obou karet najdeme šestnáct paměťových čipů z obou stran PCB o celkové kapacitě 2 GB! Datová šířka paměťové sběrnice je v obou případech 512 bitů (256 bitů pro každý procesor, 32 bitů pro každý paměťový čip).

Grafické karty postavené na jádře RV770 podporují nejnovější multimediální rozhraní DirectX 10.1 a ShaderModel 4.1, čímž získávají další výkonnostní náskok nad kartami nVidie. Zatímco nVidia se striktně drží svého standardu PhysX, ATI je více nakloněna rozšířenějšímu Havok, který podporuje více výrobců her.

Nové Radeony lze zapojit i do dvojice v jednom počítači prostřednictvím rozhraní CrossFire X. GeForce GTX lze do jednoho počítače osadit až po třech, nicméně takové řešení asi málokdo využije. Jako všechny moderní grafické karty, i Radeon využívá pro spojení se základní deskou druhou verzí slotu PCIE 16x. Protože by dodávané napájení nedostačovalo požadavkům karty, najdeme v zadní části dva přídavné napájecí konektory, jeden šestipinový a druhý osmipinový (jako u GTX 280).

Karty jsou osazeny dvouslotovým chladičem, který jsme už u některých modelů Radeonů viděli. Ten se liší pouze délkou, protože i PCB je výrazně delší, než jsme zvyklí, za což může přítomnost dvou grafických procesorů. Pasiv najdeme i z druhé strany, kde chladí zbylých osm pamětí.

Co se týče vstupů a výstupů pro připojení zobrazovacích zařízení, najdeme zde klasicky dva DualLink DVI konektory a jeden HDTV výstup.

Srovnání nejvýkonnějších karet společností nVidia a ATI…

Testy

Testovací sestava:

Procesor: Intel Core 2 Extreme QX9770 – 4 GHz

Deska: Asus P5E3 Deluxe WiFi-AP / XFX nForce 790i Ultra

Paměť: Patriot / G.Skill – 2x 1024 MB DDR3-1600 (7-7-7-18)

Zdroj: Coolermaster M850 Real Power Pro Modular – 850W

Skříň: Coolermaster Stacker 832

Systém: Microsoft Windows Vista x64 SP1

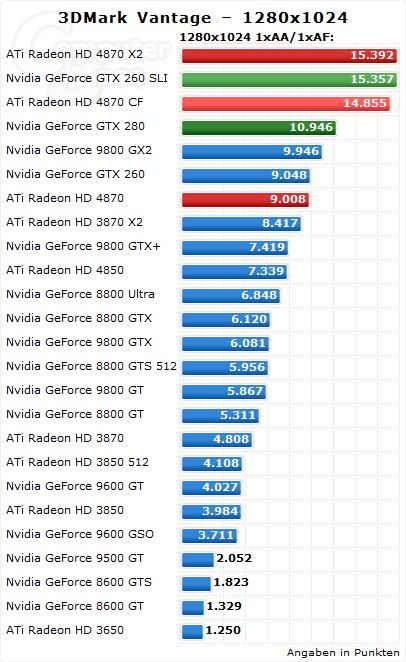

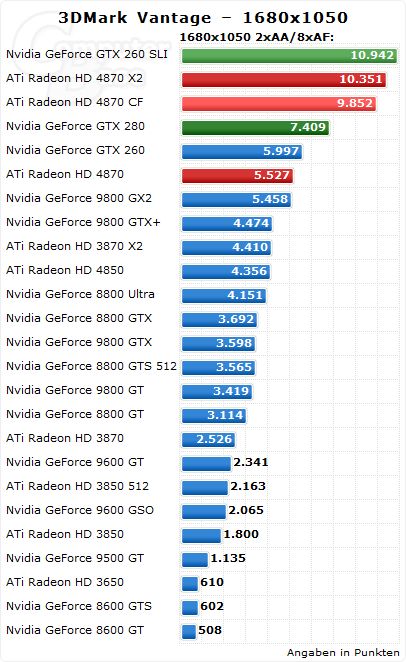

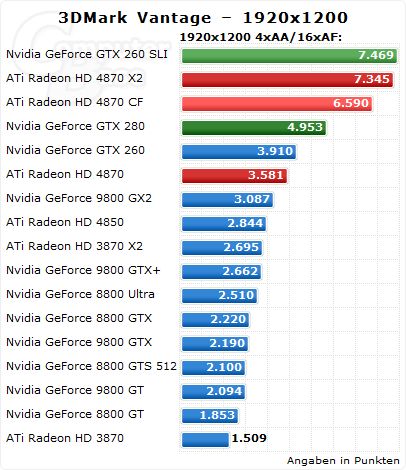

V poslední verzi oblíbeného benchmarku 3DMark Vantage v základním rozlišení 1280×1024 podává Radeon HD 4870 X2 stejný výkon, jako dvakrát GeForce GTX 260 v zapojení SLI. Samotná GeForce GTX 280 ztrácí 29 procent. V rozlišení 1680×1050 si Radeon zachovává odstup 28 procent nad nejvýkonnější kartou nVidie. Dvě GeForce GTX 260 jsou tomto případě jen o 6 procent výkonnější. V nejvyšším testovaném rozlišení má Radeon HD 4870 X2 náskok 33 procent nad GeForce GTX 280. GTX 260 v SLI překonávají Radeon o 2 procenta.

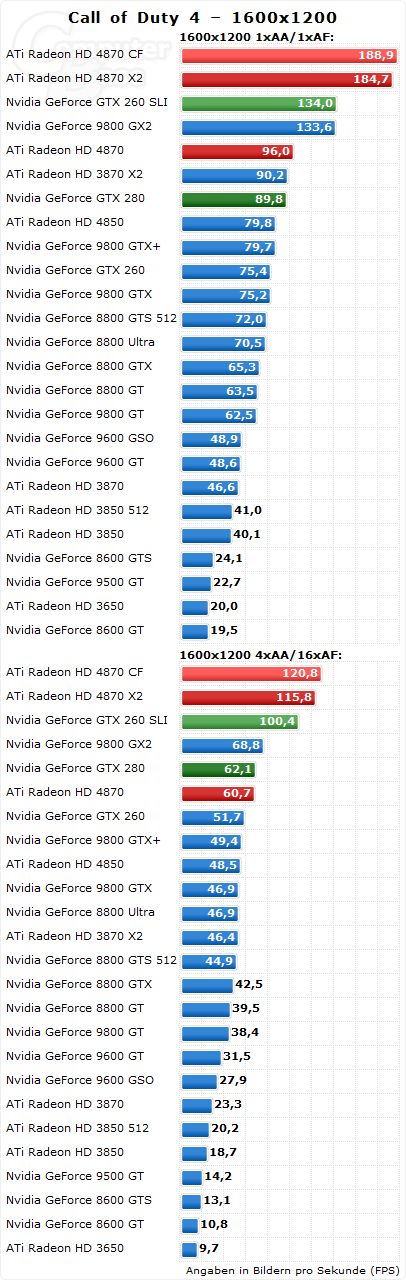

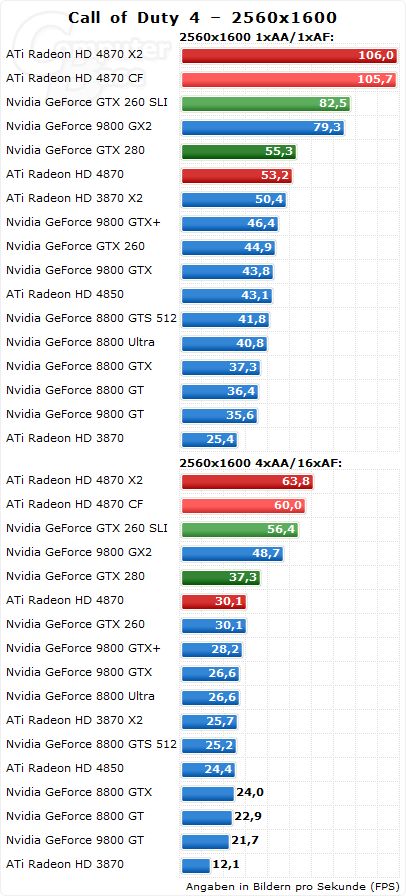

Extrémní rozdíl kolem 50 procent nad GTX 280 obdržel HD 4870 X2 v Call of Duty 4 při rozlišení 1680×1050 s 1x antialiasingem a anizotropickým filtrováním. O něco menší rozdíl se opakuje i v rozlišení 1600×1200 a 2560×1600 bez ohledu na nastavení AA a AF. GeForce GTX 260 v SLI zaostávají o zhruba 20 procent.

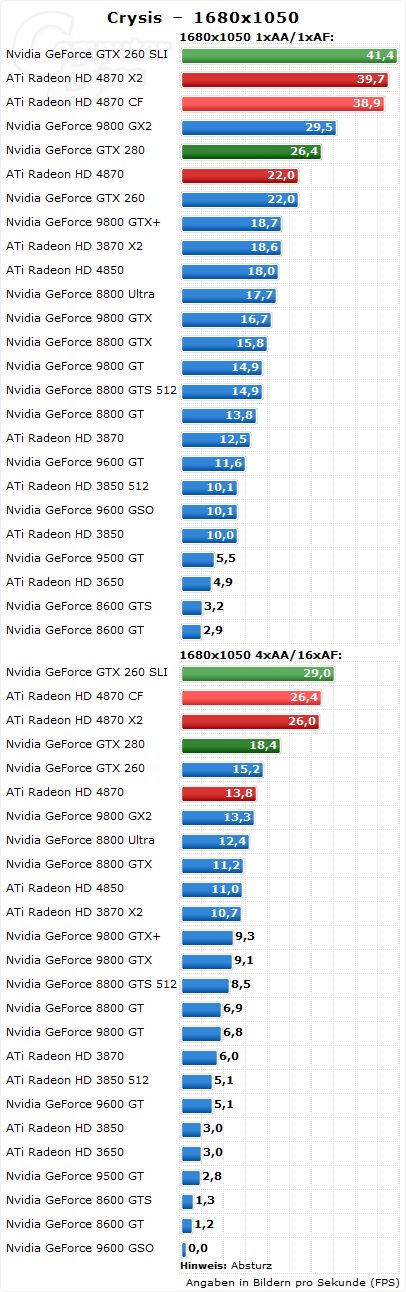

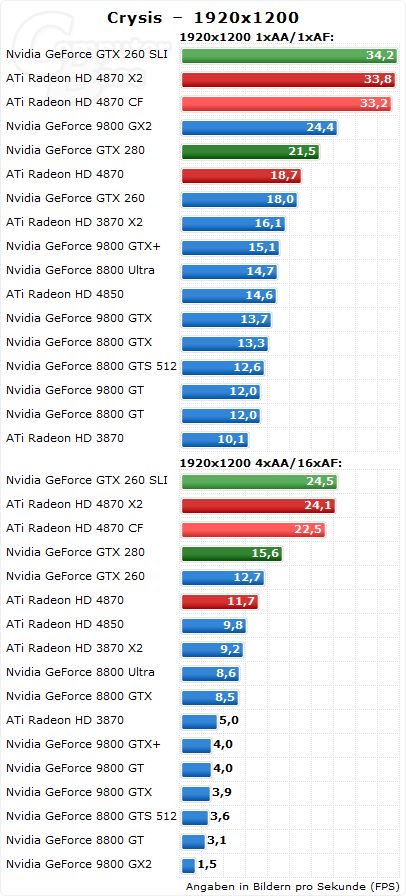

O 30 až 40% vyššího výkonu dosahuje HD 4870 X2 nad GTX 280 v snad nejnáročnější hře současnosti – Crysis. O 3 až 12% jsou výkonnější jenom dvě GeForce GTX 260 zapojené v SLI. V rozlišení 1920×1200 s 4x antialiasingem a 16x anizotropickým filtrováním je možné hru provozovat na 24 FPS, což je o 35% více než na GTX 280 s 15 FPS.

Závěr

Z výše zmíněných testů je snad jasnější než kdy jindy, že pomyslný trůn krále grafických karet po delší době opět náleží společnosti ATI a jejich akcelerátoru Radeon HD 4870 X2. Nejen že tato grafika je nejvýkonnější ze všech současných, ale zároveň se jedná od dob GeForce 8800 GTX o opravdu pořádný skok ve výkonu. Nový Radeon s revolučním výkonem přichází i s revoluční cenou, prodávat by se měl pod deset tisíc včetně DPH.

Druhý nejvýkonnější Radeon, který se bohužel do testů nedostal, bude s největší pravděpodobností konkurovat nejvýkonnějšímu modelu GeForce GTX 280 od nVidie a to nejen svým výkonem, ale jak je u ATI obvyklé, i cenou. Pokud tedy patříte mezi šílence, kteří ze svého počítače musí dostat maximum, máte ideální příležitost upgradovat a mít něco, co už tady dlouho nebylo.

nVidia se pokusí situaci alespoň částečně napravit uvedením 55nm verzí svých GeForce GTX, ale do uvedení nových karet si můžeme být jisti, že pozice nejvýkonnější karty patří Radeonu.

Jojo budu kupovat radonku tuhle a v pomeru cena vykon jasne lepsi :)

hrate hry je podla mna lepsia NVidia ale iba o malicko a to je u ritky nie?

Kazdy radsej zobere tu lacnejsiu.

ja mam rok a pul 8800GTS 640MB a vsechno zatim rozjedu na max

jako ty sis kdysi koupil svoji GTS, tak si dneska každej vybere tyhle radeony, jednoduchý... :)

až příjde novej prodejce do světa grafiky a příjde s novou natuněnou grafárnou o 50% lepší než ATI a Nvidia tak to bude nářez , bohužel , todle se NIKDY nestane :-D :-D :-D

a ja jsem vysmatej, protoze todle neresim mam Xbox 360ku a todle (uz) nemusim resit (nastesti). ;)

.. Vzdy jsem byl spise pro Nvidiu nez pro Ati.

nVidia power!!:D

atiny jsou mnohem lepší než Nvidia jak cenově tak technologicky

Proc tu neni GF 280 SLI ?:) pomer cena vykon vede ati s tim problem nemam.. ale proc tu v "testu" chybi nejsilnejsi reseni nVidie??

tak tady šlo hlavně o vyzdvižení výkonu single karty... nvidia má jeden dvoujádrovej procesor, ati má dva jednojádrový (v obou případech na jednom PCB), takže to teoreticky vyjde nastejno, ale počet stream procesorů u ati (i když na nižší frekvenci) dělá hodně... přece jenom 1600 vs 240 už se někde projeví... zajímavý by bylo srovnání 3x GTX 280 proti 2x HD 4870 X2...

Jojojo.. Tos vyzdvihl krasne.. jen se nehodi 280SLI(bo by vypadalo blbe kdyby byla ve vsech/vetsine grafech prvni) taks tam dal pro jistotu aspon 260SLI abyto nevypadalo tak zle pro nvidii, a na konci si mohl psat o nejnejnej 4870 X2:)

Asi si ji kopím xD

juhů

král je mrtev, ať žije král!

phenom 9950 be + 4870x2 + 8gb ramek od OCZ 1066MHz Platinium XTC a nebude potreba upgrade tak 2 roky..

ja uznavam (po zkusenostech) uz jen NVidii, ale tahle radeonka vypada dosts slibne a vzhledem k cene.... asi zase dam radeona

Co to je? Slambe, kde jsi prisel na to, ze GTX280 je nativni dvoujadro? Je to obycejna jednojadrova karta s dvojnasobnym poctem SP a s 512bit sbernici.

http://media.bestofmicro.com/gtx-260-280,H-R-110799-13.jpg

KOuknete na ten posledni graf jak si tam vede 9800 x2 ma tam 1,5 FPS v poho si ji dava hd 4850. jeste ze se uz nevyrabí

HAHAH

a to z jednoducheho duvodu, obe karty maji sva pro a proti.

+ Radeonu >>>> Radeon umi DX10.1 (o jeho vyuziti muzeme polemizovat), ma DDR5 pameti, je na 55nm, za cenu 10 500+ mate ve vetsine hernich titulu nejvykonejsi kartu dneska, vyresily se propady pod AA a AF, vylepseny PLX chip oproti predchozi X2

-Radeonu>>>> Spotreba v klidu i v "burn", ne prilis dobry chladic (jak je zvykem), microscuttering, je to X2 karta, opet ty ovladace

Pro GeForce >>>> Velmi dobry a ucinny chladic, podpora ze strany Nvidie ve hrach (TWIMTBP), spotreba v klidu, mensi spotreba v loadu, vykon, oproti Radeonu je levnejsi (8000+), vetsi moznost pretaktovani, jednocipova karta, ovladace jak je zvykem u Nvidie jsou pri uvedeni dodelane (anebo alespon schopny provozu)

Proti GeForce >>>> "pouze" dx10, zbytecny hype ze strany Nvidie a novinaru, pocatecni cena, velikost jadra

Obe karty bych shrnul timto >>>> pro 99% lidi nezajimave, protoze za mainstreamove ceny muzete mit skvele a vykone karty (4870,4850,9800GTX) ktere na vsechny tituly s prehledem staci.

Tyto karty jsou spotrebou nekde zcela mimo me chapani, ale kdo na ne ma tak ma i na to priplatit si za elektrinu :).

nevim kde tento "profik" prisel na to ze GTX280 ma "jeden dvoujadrovy procesor"... GTX2x0 jsou jednojadrove karty ;-)

Navic srovnavat stream procesory ATI a Nvidie je trosku vedle, obe pracuji "trosku" odlisne

Já jsem měl vždy kartu od nVidia a byl jsem vždy spokojen. Tim neřikám že ATI je horší. Pravděpodobně má větčí výkon ale jsem věrnej nVidia :)

Přesně. A napsat, že datová šířka paměťové sběrnice je v obou případech 512 bitů je taky vedle. Ati HD4870X2 ma na každém jádře 256 bitovou sběrnici (nelze napsat, že ma 512bit. sběrnici. To je to samé jak kdyby jel jeden vlak rychlostí 100km/h druhý taky 100km/h a někdo by řekl, že jedou dohromady rychlostí 200km/h) a 2x 1024MB paměti, nVidia GTX280 ma 1x 512bit sběrnici a 1x 1024MB paměti, protože je jednojádrova.

ty testy sou pokrytecký páč nevím proč tam není GTX280ka ve SLI když tam máte HD 4870 CF !!! demence

jednu vlastnim :))) a slysel sem , ze nvidie v testech slusne rozdupala :)

Ta Atina by se mi libila ale kdybych neco takovyho pořizoval musel bych překopat celej komp.

je to asi vcelku jedno!!!podle me se neda koukat na vykon a hodnoceni ale taky na cenu a vyuziti...!takže tadle recenze je zajímavá ale vcelku z ní člověk nic nevyčte

no ATI sice Nvidii dohani ale poraz vede Nvidia :) ja mam napr gf 9800 gtx 512 a crysis rozjedu na max v pohode tak proc jak kkt kupovat Radeon HD 4870 X2 bo GeForce GTX 280 ... stejne to zvisi o 20fps max a hratelnost je porad stejna...

Takovou grafarnu si koupí stejně jenom šílenec co má doma 24´´ monitor a ještě mu zbyde hodně velká rezerva výkonu vzhledem k dnešnímu hernímu softwaru a to rozhodně na nějakej ten pátek dopředu.Stejně valná většina lidí má 19´´ monitory jako já.Sám zatim jedu na gf 7600gt a chystám se koupit 8800gts,protože pro rozlišení 1440/900 to bohatě stačí a stačit bude i do budoucna,protože velká síla je i v ovladačích. a neřešim nějaké high end,který jsou pro fanatiky,kteří se tím pak chluběj,že jsou náramně IN a mají akorát spoustu nevyužitého grafického potenciálu s velkou spotřebou.Stejně rozdíl kupříkladu mezi 50 a 100 či více fps nikdo z nich nepozná a na hratelnosti jim to už taky nepřidá.

Nevim mozna v tom singlu se to da prezit. Ale v multiplayeru ? rozhodne ne.

60 oproti 100 poznam, je lepsi mit vic pac na tebe nekdo vybehne nablizko mas lepsi reflex, a hlavne pokavad se spusti nejaka graficka scena ze zacnou neco bouchat atd. fps ti muzou najedno skocit zase o 20 niz na tu chvilku, a to uz znat je. A hlavne chvilka v multiplayeru zabiji

ja sem dal na sve hd4870 13,1823d marku :)

ATI fans hiphip huraaaaaaaaaaaaaaaaaaaaa

Ja jsem to udal jenom jako příklad.Samozřejmě že v multiplayeru na tom záleží,ale tahle karta bude dávat určitě mnohem víc fps než 50 a to ve valný většině her.Ten skok z 50 na 30 by byl určitě znát,ale třeba z 80 na 60 by tě už zřejmě moc trápit nemuselo.

kcemu tyhle karty kdyz vykon stene ve hrach nevyuziju napr cod4 malo ktery profi hrac pouziva max graf. nadupany config vetsinou pouzivaji max low detaily config, a jestli si nekdo mysli kolik bude mit fps tak punkbuster ho pekne zkrouhne na 120 nebo kolik to je FPS/s tyhle karty je zbytecne kupovat alespon pro me, protze vzdy zjistim ze za pul roku tu je zas nova karta a jeste vykonejsi.

8800 GTS 512 rulla

myslim ze tyhle testy nejsou vubec obektivni mam 24" monitor na rozliseni 1920x1200 a videl sem ze Nvidie ma v testech napr na toho rozliseni v AAA titulech lepsi FPS jak nejake ATI take ma Nvidie daleko daleko lepsi technologie vysli nove drivery kde kdyz pouzivas physX kartu nebo kdyz mas napr tuhle Nvidii a koupis si napr levnou GT 8600 tak si GT muzes dat aby vypocitavala fyziku pokud si stahnes physX software v dosavadnich hrach je to jen minimalni rozdil ale hry co probezne vychazeji uz maji daleko lepsi fyziku take pristi snad uz pristi rok bude directX 11 ktere by meli plne podporovat fyzicke akceratory physX takze se uz dockame velice realnych her a to diky Nvidie technologii a ati budou vyuzivat tuto technologii jen diky Ageia physX kartam vyrabene Nvidii

priste az tu budes neco srovnavat tak to udelej obektivni napr nevidim tu call of duty na 1920x1200. profesionale!

Chudak ma 3870 :D

To ani nechtěj , protože od řady 8xxx má s COD nVidia těžkej problém.

bylo to pro starouškolu

zadny problem sni nemam driv sem mel problem ze slabym fps ale to sem vyresil novym vetrakem na procaku tamten se nejak poto a uz od rady 8 muzes mi na misto grafarny fyzicky akcelerator

navic pokud ja vim tak 25 fps je bezne hratelne televize vysila 25fps a jen nektere americke filmy maji 30 fps jinak to lidske oko stejne nerozlisi

ati je naklonena havoku to mas pravdu ze je vice rozsireny ale neni zdaleka tak dobry jako PhysX takze nevim proc je to vetsi ATI naskok navic bych polemizoval o vyuziti directX 10.1 zanedlouho stejne pride DX11 a pokud je mi znamo navazuje na DX 10 takze ho budou podporovat soucasne Nvidio 8 rady a vys

samozrejme sem to rekl trosku nadnesene, ale proste mam radost, hadal sem se o tom hodne dopredu s kamosem.

Na první pohled moc nevěřím výkonu 8800GT, která je o 1/4 výkonější než 8800GTX a v testu to je přesně na opak... také fakt že 8800 Ultra je lepší než 9800 GTX se mi nezdá, ale teď k kartám

řada ATI HD 48xx

+ určitě výkon,moderní technologie a cena

- teploty karet, SPOTŘEBA, přetaktovatelnost... ( do 7%, ale průměr jsou 4 % )

řada GF GTX 2x0

+ teploty karet, spotřeba, přetaktovatelnost ( vtom měli vždy + GF... efektivně i 20 % ), hlavní plus pro mne je podpora CUDA, což nemají karty ATI a lepší ovladače

- cena oproti konkurenci, slabší výkon oproti konkurenci, výkon ve SLI, ale musím dodat že SLI je efektivnější než crossfire o 40 %.

Co je to CUDA?

Je je technologie, která podporuje Phyxs karty, nebojak se to píše.. nárust výkonu v moderních hrách i 150%...

Phyxs karta je jinak řečeno Grafický herní akcelerátor fyziky, který počítá veškerou fyziku ve hře a dá se sehnat za 2700,- v alza

Celkové hodnocení

Tyhle karty neřešim ( GTX 280 a HD 4870 X2 ). Podle mne je to žrout elektřiny... a stejně je nejvýhodnější střední vyšší třída... Tohle je jen pro "fajnšmejkry"... jinak je dobrej test v novém computeru ( myslim vtom časopisu ) - GTX 260 vs. HD 4870... stojí to za přečtení

Cuda mají nvidie už od 8 řady

cuda je programovaci jazyk ne? C ci C++ ATI ho nema proto dava vetsi prostor vyvojarum ale cuda je mnohem efektyvnejsi

navic karta PhysX za tech dva sedum je slabsi jak GT 8600 novinkou je ze se daji Nvidie rady 8 a vys pouzivas jen jako graficke akceleratory takze pokud mas GTX 280 a mas doma nejaky osmickovy GTcko ci neco takoveho tak ti to moc k FPS nepomuze proto stahnes software na PhysX a nastavis si jednu s tech grafaren na fyzicky akcoch (ja bych volil tu slabsi);)

prvne aktualizuj ovladac svoji karty osme rady a vyse a pak staji tenhle soft http://www.nvidia.com/object/physx_8.06.12_whql.html pise ze to podporuje jen 9 a vys ale osmicku take tam nastavis ty multi cory aby jedna fungovala jako akcelerator fyziky a pude to ve vsech hrach akorat ze zatim moc rozdil nepoznas ja doufam ze stim zacnou hodne pracovat vyvojary AAA her jinak napr to vyuziva UT 2007 jakoze tam uz rozdil poznas

tak o tom ze urcis nakou kartu jenom pro vypocet fyziky a druhy nechas minimalne grafiku, tak o tom uz sem neco taky pocetl. Ted si nejsem jistej, ale nakonec z toho vyplyvalo, ze se to u lepsich karet nevyplati jednu urcite jenom na fyziku, ale proste nechat v SLI jak to lezi a bezi

podle tutoho bych se asi vykašlal na NVidii a šel bych do aty... jenže když má takovej výkon co příkon? to abych si pořídil kapesní jadernou elektrárnu omg...

fuj nvidie sracka

AMDcka udajne odmitly podporovat PhysX docetl jsem se to tu: http://rss.mozektevidi.net/item/30164.htm coz by do budoucna urcite amd (ati) ohrozit mohlo vzhledem k dokonalosti PhysX nevim jestli zabrani aby nefungovat fyzicky akcelerator od ageia (nvidia) v souladu z grafickymi kartami ATI pry ze nadale budou podporovat havoka ale pokud ho poradne nezdokonali tak tak ati dopadne stejne jako to dosud bylo z fyzickyma akceleratorama od nvidie dosud byly vyuzitelne v minimalnim poctu her a nebyly zrovna nejlepsi takze nvidie ted diky tomu ze si lide nemusi koupit primo fyzicky akcelerator utezi na tom ze konecne tvurci AAA her budou pracovat na jejich http://www.extrahardware.cz/physx-pack-1-milnik-hernich-dejin?page=0,6 zde jsou moznosti zapojeni, neco o PhysXu a ucekavana hra pracujici na PhysXu je FarCry 2 kdo videl gameplay video jiste uz vi jen si vystrilej se do stromu zasobnik a uvidite jak jednotlive budou padat vetvicky nebo strelte bazukou na chatek takovehle destrukce, sirici ce ohne dokaze jen PhysX takze kdo se tesi na far cry 2 by si mel poridit nejakej akcelerator fyziky

jenze chapes ze ta hra se chova uplne jinak na 25fps a 200fps?

sry za zmateny vety v minulim komentu nepsal sem to naraz a ruzne jsem si vyhledaval i zdroje takze jsou tam trochu pomatene souvezi

podle pár testů je nic moc oba jsou vyrovnane , ale nVidia má lepší tvýkon ale v COD 4 už sice moc dobře nevede(špatne ovladače nebo hra ma špatné problémy s SLI) ale v Cryssis ma dobre výsledky. Počkáme na další testy, někde na svethardware.cz , extrahardware.cz nebo také pctuning.cz

chapu pokud mluvis o CoD 1 kde jsou spatne FPS uvedene ale pokud mas hru na 25fps nebo 1000 tak to nepoznas pokud jsou spavne uvedene FPS

take vis ze napr zarovka ti blikne asi 50 krat za vterinu? vnimas ze blika? takze myslim ze 25 snimku za sekundu je dostacujici navic i tvuj monitor ma omezene FPS snad se nemyslis ze kdyz tvuj komp da 100 fps ze ti tolik fps monitor zobrazi?

takze myslim ze nvidie prevalcovala ATInu: http://www.extrahardware.cz/duel-geforce-gtx-260-vs-radeon-hd-4870?page=0,29 tenhle clanek beru protoze je tu mnohem vice testu a je tu mnohem vice informaci a nesel sem si ho uz jen proto ze se mi mnohem vice libili vysledky pouzitych karet je to fer top Nvidia vs. top ATI je sice levna ale slaba

U televize je to tak,že při 24 fps za vteřinu je vše absolutně plynulé,ale při hře samozřejmě ne,protože to funguje trochu jinak:)

napr i cod je na vyse zminem odkaze proste lepsi jak na radeonech a tyhle vysledky jsou divne jako jedna grafarna od nvidie 9600 GSO ci co ma call of duty na 0 FPS aha? fakt dobry

V např. akčních scénách je obraz plynulý,ale jaksi rozmázlý:)

Jezisi to co tady pises je fakt hodne mimo.

Takze pekne od zacatku:

Nvidia ma pokrocilejsi technologii? ATi vyrabi cipy na 55nm vyrobnim procesu, nVidia na 65nm procesu, Ati podporuje DX10.1, nVidia DX10, ATi pouziva pametovi radic HUB pred tim melo Ring-bus pred tim hybridni ring-bus a pred tim nejstarsi crossbar ktery dodnes pouziva nVidia, ATi uz pouziva graficke pameti DDR5 a pak jsou tady takove drobnosti jako je treba AVIVO. NVidia ma jedinou vec kterou ATi nema a to je PhysX.

COD4 na rozliseni 1920x1200.. Ty testy nedelal on ale jsou zkopirovane z Computerbase dole ve zdroji je uveden.

A 25fps podle tebe staci na hry? Ve filmech je to dostatecna frekvence ale to protoze ve filmu mas pouzity motion blur, kazdej snimek je rozdvojenej na dve casti a pouziva se tzv. prokladani obrazu takze liche radky s pixely ma o par milisekund starsi verzi obrazku nez sude radky pixelu.

Cuda programovaci jazyk? Hehe to snad nemyslis vazne, CUDA se programuje v C.

A tvuj srovnavaci test: Sice je nVidia o par procent lepsi (rozhodne atinu neprevalcovala!!! hlavne v tvem oblibenem CoD4) nez ATi, ale dival jses taky na ten pomer cena/vykon.

Tod vse..

0 fps zrejme protoze na ni nefunguje... Testy rozhodne divne nejsou kdyz jsou z Computerbase coz je duveryhodny server.

vis ja tenhle testuje 2 hry muj zdroj jich testuje pres 10 takze uverim jemu navic nema tak namakanou sestavu jako pisi tu a pritom tam graficke karty dostahuji lepsich vysledku

dx 10.1 vs dx 10 nevim k cemu potrebujes dx 10.1 kdyz ho podporuje jen assasins creed a stejne nvidia a stejne diky nvidii tvurci her ted pracuji pro DX 10 a ne 10.1 jo muzes mi priblizit to stim fps ve filmech a televiznim vysilani? ja jsem o nicem takovem necetl a kdyz si sam vytvorim mov video v 3dmaxu z 25snimky za sekundu jde to krasne plinule to same pri hre zkus si zahrat nejakou hru dej maximalni fps 25 cod 1 nezkousej to je z fps nejake pomatene ale i kdyz se nad tim zamyslis myslis ze stihne tvoje oko sejmou 25 snimku (at jsou jak koliv prolozene tim cim rikas) za sekundu? koukni na stopky kde mas setiny myslim ze na nich nezaregistrujes 25 ruznych cislic proste lidske oko neni tak genialni

25 snimku ve hre trha ocima, rozhodne to neni plynulost, v takovem crysis kterej pouziva malinko motion blur je to trosku plynulejsi.

Kdyz zastavis na televizni obrazovce (nebo nejaky film) obraz kde treba prave projizdi formule co uvidis? Pekne roztahlou rozmazanou formuli. A kdyz to udelas v nejake hre uvis krasnou, grafickou, nerozmazanou formuli. Je to zpusobeno prave tim prokladanim.

DX10 je nedokonalej, DX10,1 je "opatchovanej" DX10. Blizard ho urcite ve hrach co vyda zahrne.

Tady jeste takovej dukaz o tom ze 25/30 fps neni plynuli (zdroj pct forum):

Stahněte si a nainstalujte 3dfx Demo "60/30/15 Hz" z http://www.falconfly.de/artwork.htm (zascrollujte, nebo si na stránce vyhledejte název dema - přesně jak jsem ho tučně uvedl)

Pokud nemáte v systému nainstalovanou grafickou kartu od 3Dfx ani Glide wrapper, stahněte a nainstalujte např. wrapper ze http://www.zeckensack.de/glide/ (hned druhý řádek shora "download here")

Po instalaci wrapperu zkopírujte soubory "glide2x.dll" a "glide3x.dll" z c:windows do adresáře s 3Dfx demem (do stejného adresáře, jako je exe soubor)

Spusťte configurator glide wrapperu, ignorujte hlášku, nastavte Refresh rate na 60Hz a zavřete (OK)

Otevřete CCC (nebo ovládací panel grafické karty) a pokud používáte v-sync a 3D refresh rate override, přepněte ho na 60 Hz (demo by jinak neběželo korektně na 30 a 60 FPS). Pokud pro každé rozlišení nastavujete refresh zvlášť, mělo by stačit nastavit těch 60 Hz pro 640*480

Spusťte demo a kochejte se, jak se balónek při 30 FPS pohybuje "naprosto plynule, že už je jakýkoli vyšší framerate úplně zbytečný"

vzdyt jsi tam sam napsal nebo ten kdo to psal tam uvedl ze pri 30 fps jde vsechno krasne plynule a nema smysl zvysovat framy sem rikal ze 25 fps vysila televize a jen par americkych filmu ma 30 fps pak uz nemas sanci rozdil poznat ve hrach je to jinak protoze si myslis ze mas treba 25 fps kdyz je mas tak to de plynule kdyz zacnes strilet tak se to muze trhat protoze ti FPS klesa pri zatezi

To jsem tam ja urcite nepsal protoze to neni pravda. 30FPS je pro hru urcite malo, takovych 60 je naprosto plynulych a rozdil mezi 60 a 1000 neni pozorovatelny.

hele tak jsem na to prisel nejlip to zjistim tim ze si pustim animovanej serial napr simsni, futurama, family guy... delane na kompu 25 fps zadny proklad jak si rikal proste kdyz to stopnes muzes videt kraznou hvezdnou lod nijak rozmazanou a pritom kdyz leti tak se vubec neseka proste jestli je ve hre vterina jako vterina jesti je tam fram jako fram to fps znamena frams per second pocet snimku za sekundu tim padem 25 fps je plinuli obraz jak s tim tvim maznutim ktere je zapricineno kamerou tak dokonale ostrou grafikou takze stalich 25fps ma byt a je napr v HL 2, UT 2007... naprosto plynula hra

takovadle logika ti fakt staci jen na cod!!!:P

Ty jsi asi neskousel to 3dfx demo na ktere jsem nahore poukazoval co? 25fps je pro hru rozhodne malo, s plynulosti to nema nic spolecneho. A to, ze kdyz jsi zastavil obraz v animovanem filmu a nemel jsi ho rozmazany, neznamena, ze princip filmu nefunguje tak jak jsem psal. Obraz jsi nemel rozmazanej, protoze jsi tam nemel dostatecne rychly obekt aby se to dalo pozorovat.

....

ty testy mi prijdou nejake divne...ty fpska neodpovidaji zahranicnim serverum

vem si to tak vec uleti 100 metru za vterinu k? mas 25 snimku tu znamena ze ze snimku 1je na 0 kdyz si vytvoris pomyslnou osu na snimku 2 je na 2,5 metru od zacatku je to ohromky skok ale diky tomu ze leti tak rychle to nestihnes vnimat stahni 3ds max vytvor si kostku zapni autokey hod se na 25 snimek a posun kostku napr po ose X o 100 metru prvne take nestav metriku ale to je vedlejsi udelaj z toho muvicko a uvidis ze se hybe rychle a diky tomu nestihas vnimat ze se posunuje o 2,5 metro kdyby sis to poustel po snimcich;) a je uplne jedno jestli je to hra nebo film proste pokud nelzou udaje tak to nepoznas na profilu mas neco spojeneho z cod tak sem se o tom zminil protoze hraju cod jedna a rozdil poznam mezi 75 a 125 fps

neodpovidaji ani ceskym serveru:D

Já su pro GForce,a co třeba NVIDIA PhysX ageia to ATI nemá!!!?

ati je stereotypni spolecnost ktera se vzdala PhysX jen kuli tomu ze je od konkurence ale pritom havok je od intelu to je take konkurence sou to nobraini

Jezisi to je stebou tezky, snazil jsem se ti to tu vysvetlit ale ty jsi to nepochopil. Stahni si 3Dfx demo a uvidis ze mezi 60 a 30 fps je sakra rozdil kdezto mezi 75 a 125fps rozdil neni zadny a to protoze tvuj monitor nezobrazi vic jak 75 snimku za seknundu (pokud mas LCD).

A testy nejsou vubec mimo, odpovidaji realite a uz nerikej, ze ne. Na zadnem ceskem webu jeste recenze na HD4870X2 zverejnena nebyla krome DDworld jenze tam jsou vysledky uplne mimo. Vsude je to pouze okopirovane pouze od Computerbase, Guru 3D a podobnych serveru.

Odakz:

http://www.computerbase.de/artikel/hardware/grafikkarten/2008/test_ati_radeon_hd_4870_x2/

tim ti rikam ze cod nema fps aspon nevim co cod povazuje za fps ale v cod poznas rozdil mezi 75 a 125 fps je mi jasne ze tolik nezobrazi monitor ale cod je trochu pomatene v tomhle ohledu take kdyz mas omezovac na 125 fps tak skaces vys a dal coz je nesmysl proste nevim co je v cod fps ale ma zobrazovac fps ktery ukazuje nesmysli

No ty si asi tezkej dement xD Vis co nainstaluj si Counter Strike, nebo Vetcong a pust si to jednou na 25 FPS a jednou na 70 FPS :D:D:D myslim ze pri druhe variante trefis o neco vic... PROBOHA demence je neomezena vazne to je halda tohle xD

Spise nechapes... nejmensi frekvenci pro plynulost pro lidske oko musi byt pouzito alespon 25 FPS avsak v v PC hrach ktere nepouzivaji prokladanost takzvane pulsnimky potrebujes alespon 60 FPS pro uplnou plynulost a nezadrhavani.

A luxus největší !! Takže max spokojenost ! :)

nechci tu bejt zprostej ale vzapamatuj se nainstaluj si to CSko a zkus to hrat pri 20 fps. Strileni mne nebavi proto jsem se stal jumperem a pokud nemam fps minimalne 100 - 90 tak si ani neprdnu jelikoz ty obrazky jak ty mektas ze 25 je plynulych asi nevis o cem meles

http://video.google.com/videosearch?q=exilim+F1&sitesearch=#q=casio%20exilim%20F1&start=30

Video nataceny 1200 FPS tady vidis i to tvoje blikani světla hahah

Pardon spatne video v predchozim komentari:: https://www.youtube.com/watch?v=ZiilgufB0PI&eurl=

https://www.youtube.com/watch?v=i0SnYaByCek&feature=related

tak tohle je super článek a docela se mi zamlová ten ATi Radeon ;)

A všecky hry na UT3 enginu jako Medal of Honor Airborne, Bioshock a.j.? Nebo je to dany pouzitym fyzikalnim modelem? Na Havok jsem zvyklej, ale i tak fandim Physx... Moje grafarna je Ati X1650PRO 256MB GDDR3 AGP8x, takze si na tom zatim stejne nic nezahraju... Asi upgradnu na X1950PRO anebo na HD3870 ci co to je do agp slotu... Muj monitor, 17p CRT takze stejne to chce lcd:)

ty vole radsi si za par stovek porid desku s PCIE xD

docela dobrý přehled o grafárnách ne??

No tak zaprvé (to bylo kdesi na začátku) 280 má dvě identický jádra vedle sebe, to nutně neznamená že celá deska je zdvojená ... jsou to jen SPUs (nebo jak jim říká Nvidia))

Za druhé s tou plynulostí je to tím že u televize je každý snímek de facto zobrazen 3X .. motion blur by to vlastně musel u počítače emulovat ...

no a za 3tí .... 280 je v SLI technicky na tom stejně jako 2X 4870 X2 v CF... no dobře možná ne úplně ... X2 je přeci 2-čipset, ale je to pořád uzavřená jednotka, NE SLI(CF) .....

Výborná recene je na www.anandtech.com, ale je v AJ ...

Když už se tady tak pěkně hádáte o Fps,tak jen tak pro informaci.- od nějakých 32 fps lidský zrak vnímá obraz jako naprosto plynulý.Samozřejmě je důležité aby Fps bylo u her minimálně 50-60 fps a to na spodní hranici při plné zátěži (zejména zatížení HW při při vykreslování fyzikálních efektů),protože při tomto stavu je hratelnost už velmi dobrá a rozhodně dostačující i pro multiplayer.Pokud chce někdo tvrdit,že pozná rozdíl mezi 60 a 100 tak má na týhle planetě hodně abnormálně vyvinutý zrak.Jinak co se týče filmů,u nich je kapánek jiný způsob vykreslování a tam těch 25 fps stačí,protože filmy mají z podstatné části rychlý běh a rychle se měnící scény ale pokud dojde na dlouhou scénu,kdy se zabírá delší dobu jedno místo s pomalým sledem,tak je tam ta trhavost poznat.Sice minimálně ale je.

AGP slot?

Na to se už vys*

Kup si novou základovku.

Nějakou grafárnu(v pohodě do 5 tisíc seženeš).

Pokud ti nejde o Crysis, tak upradge uděláš bez problému.

Ale je to tvoje věc.

Určo kup nový procesor.

Když z těch dvou, tak spíš tu druhou.

Přece jen ta první je notně zastaralá.

Když něco koupit, tak alespoň mainstream.

Nejde nejak moc o oci jako spise rychlost vykreslovani to ej fuk je to na dlouho ale ve hrach rozhodne rozdil mezi 60 a 100 FPS rozeznas.. zkus si zahrat napriklad Counter Strike.. jednou si omez FPS na 60 a pak si dej 100

Uvidis a hlavne ucitis rozdily, tva reakce bude o poznani rychlejsi.

kde zjistim to fps kdyz hraju

buďte rádi , že máte vůbec nějakej komp :-D

No ty si vul :D:D:D, fakt dobra hlaska. tomu rikam slovo do pranice

Přesně tak, Atiny jsou cenově dostupnější a poskytují i lepší výkon. S Ati 3750 HD - 512 MB, jede všechno na max, i ty nejnovější hry.

Moc mi tu chybí cena, pokud tu je, tak se omlouvam, ale nenasel jsem ji :(. Staci jen nejaka orientacni...

hmm no framerate (nepřecházející) víc jak 25 fps je zaznamenatelný okem ... resp. není plynulý, tj. snímky "nepřecházejí" z jednoho framu do druhého, ale jsou nahrazeny následujícím ....

mmch programuju v OGL, navíc bež se zeptat třeba na gamedev.net XD

25 fps ,to je celkem blbost aby jela hra plynule

ptate se proc tu neni SLI GT280 ze by se to pak zelenilo ? tim padem by se sem mel dat i CF 4870X2 aby to bylo vyrovnany jelikoz ted tu sou proti sobe GT280 a 4870X2 a GT260(SLI) a 4870(CF) ne jenom ze Nvidioti musi rejpat protoze uz nemaj TOP jinak nejsem fanATIc i kdyz mi tu drima HD2600xt a CUDA ? na co kolik zvas hraje Ghost recon, nebo UT7 i kdyz to utecko i jo nebo mi napiste v jakejch jinejch gamesach se to vyuzije ?

rozdil mezi 60 a 100 fps poznas kdyz hrajes csko jak uz nekdo psal zkus si to sam a uvidis asi ne hned ale po tom co to hrajes dil tak jo a jak pises asi se tim vylepsujou smysli kdyz hrajes hry a ne ze je stracis : )

mam hd4870 oc

jadro 790mhz (o proti 750 default)

pameti 4400mhz (o proti 3600 default)

defaultni chladic,a zadne prehrivani po overclokingu,s chlazenim ma problem jen hd4850, hd4870 ma stejny chladic jako gt200 - ve hrach mam narust az 20 procent po pretaktovani a ve vetsine her porazi i gt280

cod4-dx9-vse na max 4xaa 16xaf 1440/900 - 90-250fps hrat to na low je totalni ulet,takove grafiky sou prave proto tak vykone aby ste si tu hru uzily,takze nevim o zadne graficke rezerve

co se tyce dx10.1, tak na 10.1 podavaji radeony vetsi vykon nez na dx9 takze si to spocitejte, spousta her brzo prinese imlementaci dx 10.1 takze jedine prinos

40 fps = hra jede plynule a nemate obtize s hratelnosti

tento test je uplne o nicem protoze autor porovnava fyzicky jednojadrovou kartu s kartou co ma dve plnohodnotna jadra propojena pres interni CF geforce je sice uvnitr rozdelena ale jinak se jedna takze ty dve interni jadra vykreslujou scenu najednou a nedeli se o ni jako dve skutecna jadra ATI ktera pracuje v CF modu takze proto jsou vysledky geforce tak slabe oproti radeonu.

ze se jedna o test dvou stejne drahych karet??????

a je sumafuk jesli sou jedno dve ci ctyrjadrove

amd proste tento souboj vyhrala s prehledem ,a nvidiari se s tim nemohou smirit

Je to zajímavé, vždy vedla nVidia a najednou to je Radeon? Možná nVidia vrátí úder novou chystanou kartou.

že už že všem jasné, že Ati je zpět!!!

chci novou grafarnu....

Nvidia

geforce se mi moc neosvedcilo

se neni cemu divit ze radeony ted vylcujou nvidie je to tim ze ATi ma vyspelejsi technologie pokud ste si vsimli ze nvidia teprve ted prisla GDDR3 a radeon uz ma GDDR5 :) a i vyrobni proces je lepsi nez u nvidie

mam geforce 9800 Gt a uplně mě stačí

drive sem preferoval spise Nvidii ale pri srovnani ceny a vykonu je jasny kral ATI

for ever

Za prvé bych řekl, že porovnávat jednojádro s dvojjádrem může asi jen deb*l, ale budiž. Teď k tomu co píši v nadpisu. Jasným králem podle tohoto testu je nVidia a to přesně GTX280, protože je nejlepší mezi jednojádry a pokud by jsme ho zapojily do SLI (vzniklo by "dvojjádro" jako u 4870 x2), což do tohoto testu radši nezařadili, výsledky by byli také nejlepší.

dobrej clanek pekna recenze

ale asi bych dal prednost GeForce nevim nevim

ale ten radeon je asi lepsi

Nvidie bude prostě vždycky lepší řeknem si za pár měsíců .... :-)

jdeto

GeForce je kráálll!!

ATI is best

no každa grafika vypada dobře ve hře jinak obě dvě jsou dobré ale která je král to nevím :D

tak me se libi obe :) ale myslim ze bych si nekoupil ani jednu :)

tak to jo

do této doby sem měl celkem slušnou radeonku ale posrala se me a tak sem zkusil Ge Force se stejnou pamětí a už si nikdy nekoupím nic jinýho protože Ge Force je king

JE jasný že 4870x2 převalcuje jednu GTX280 , ale jak koukám tak GTX260 v SLI skoro převalcuje 4870X2

Je to sporné kdo je král každá karta má něco do sebe a rozhodnutí je taky na každém z nás. Já osobně jsem pro nVidii

ATI holt zase zvýtězila, a Nvidiářům nezbývá nic jinýho než to že: "Nvidia je prstě lepší". Už Nvidia prohrává smiřte se stím!!!!

ATI je nejlepší

Ati je jednoznačně lepší, je všestranější, NVidie podporujou hlavne hry

jj Geforce je lepsi

jednoznacne je kral GeForce. mam gtx260 a sem sni nak miru spokojen

nvidia

Nvidia je nejlepsi, hlavne po strance ovladacu a ty jsou u drahych karet docela podstatny. A hlavne koho by bavilo porad tahat novy ovladace od ati skoro kazdy mesic doufajíc, že už doladily všechny mouchy.

....

HD4870 (x2) je v tejto dobe naozaj najlepsia karta v pomere cena/vykon :-) myslim ze neni nad cim uvazovat ak sa niekto chysta kupit novu graf. kartu. Nvidia to bude mat teraz tazke, ATI ich rozbila na plnej ciare...

je nejlepsi

jj

ATI is BACK...!!

vzdycky mela navrch geforce ale timhle tahem si radeon prilakala dost hlavne hracu, ale HD 4870 X2 je vykonnejsi na graficke aplickace vice nez na hry...je ale velmi divne ze ji GTX 260 SLI ve vetsine her predbiha a samotna GTX 280 je vzdy niz nez obe...ale samotna GTX 260 je jeste pod GTX 280...GTX 260 SLI je vykonejsi nez HD 4870 X2 jen diky shaderum a ma take o polovinu vetsi pocet transistoru...ale osobne si myslim ze aby GTX 260 SLI plne prekonala HD 4870 X2 tak by musely byt v pocitaci 2 tyto karty...driv jsem silne zastaval nVidie ale touto kartou si me ATI ziskali a myslim si ze to take souvisi se spolupraci (spise donucenou spolupraci) s AMD...urcite bych si ale ted koupil HD 4870 X2...samozrejme mit na to finance

tak jako u me preferuje ATI

ati jsou nejlepsi nez nvidie a o hodne .

Jak tady melete že GF260 GTX SLI je lepší než ATI HD4870X2..tak to sice je pravda,ale podívejte se sakra na začátek článku-GF 260 i 280 jsou dva čipy,pouze jakoby sloučené,takže něco jako dvoujádrový procesor-takže se od Radeonu neliší,a lze ji plně srovnávat...a 260 GTX SLI jsou pak 4 čipy,a vzhledem k ceně dvou 260 je to holý nesmysl.HD4870X2 je ted prostě best

no newim nevim ale me staci graficka karta na 1 GB a nejak bych t o neresil

jistě jedině geforce ati jsou sity a mají problemy s ovladači někdy-mel sem novou ati a proste se neshodla s mym komplem, koupím si geforce a vše je bez problémů

stejně nejlepší karta bude geforce 295 gtx

Před 5 lety bych řek nVidia. DNes rozhodně ATI....A budu to tvrdit pořád. ATI převálcovala nVidii.

is best

Je nejlepsi.ps.s grafickou na hry nejít pod 10000Kč

To jako myslite vazne ze cerpate ze zdroje wikipedia ??

mam ATI 3870 X2 a som maximalne spokojny...s nicim nemam problem na full detaily...kupil by som ATI 4870 X2...

Ati hd 4870 x2 je 100procent nejlepší grafika nasvětě a nemyslim ze Nvidia nekdy překoná ati nn ati je best

ja mam 9600GSO a sem spokojeny, jen te pameti by to chtelo vic, vsechno jedu na full, crysis se s tim da taky hrat na full pri 1440x900 bez AA, takze myslim mit to ve SLI, tak nepotrebuju davat 2-3x tolik za tyhle hi-endy :)

mno tahle je dobra mam o 100% horsi mam jen geforce 5200fx :(

AA

co je lepsi karta geforc9600gs 512mb ram nebo ati radeon 3650512mb ram????

všechno mi zabalte a pošlete domu:D a ještě to zaplatte

Jedině věci značky GF....

Já má rád nvidia je to cena výkon

ATI jsou sice o něco výkonější ale ty ceny.

všimli ste si někdy že se dycky srovnává ta nejvýkonější a nejnataktovanější karta jednoho výrobce s tou nejslabší a nejhůř nataktovanou od toho druhého výrobce?? to pak zkresluje výsledky...a ne jen u grafik...ale to i u procesorů...

mam uz roky svoji radeonku...pokazdy vymenim za lepsi ale vzdycky je to radeon...nedam na nej dopustit...

ATI 4EVER

opět zajímavé čtení díky

Pro mě je jasnou volbou ATIna... =o)

ati radeon je naj !!!

tka se divam ale neni to nic moc

nVidie jsou nejlepší, Ati bych nechtel, ani zadarmo... pro mě je král nVidia

nVidia je prostě nejlepší, proti Ati nic nemam, ale pro mě je král nVidia

Nic proti GeForce.

Ale jsou dvě kategorie Ati nebo nVidia, to je same u procesorů jedna skupina Intel a druha AMD a nikdo na své nedá šáhnout kamárád ma nVidiu a je sní naprosto spokojen ja mam zas ATI a taky bych neměni, souboj těchto firem je dlouhý a nikdy neustane to samé jako souboj jejich fanoušku mám doma x2 4870 a neměnil bych prostě jsem od provopočátku fanoušek ATI proto bych neměnil být zastáncem nVidie tak bych určitě měl jejího konkurenta...........

Gymli92 souhlasím s tebou, GeForsky xD sou nejlepší

já mam ATI HD 2600 xt DDR3 (512MB) a rozjel jsem třeba cod 4 na full

neviem preco sa tie firmy nespoja a nevymysla nejaku grafiku zo styrmi grafickymi procesormi

zbytecne

nejlepší jsou Nvidia

a hlavne levnejsi

Každý má svůj názor která grafika je lepší...Jestli GF nebo Radeon...protože každej má snima nějaké ty zkušenosti.Já osobně mám Radeon HD 4870X2 a nevyměnil bych jí za žádnou jinou grafiku...Je pro mne nejlepší

vše koupím ale zaplatíte to vy?

nvidia je lepsi...ale obe tyto firmy maji potencial jako rpase..to je neuveritelny jak se ta technika vyviji

Ja mam nvidia pro mě je on král :D

Kdyz grafiku tak Geforce

když grafiku tak jedine Nvidii

Mel jsem vzdy Nvidiu a nemel jsem problem,znam par lidi co meli Ati a ti problemy meli.Takze ja zustanu verny Nvidii :-)